L’IA n’a pas fini de faire parler d’elle. Cette semaine, le journal La Libre rapportait un drame : un jeune père de famille, devenu très éco-anxieux, s’est donné la mort après six semaines d’échanges intensifs avec un chatbot nommé Eliza. Quelle est cette technologie et quels sont ses dangers ?

La Libre rapporte le destin tragique d’un jeune Belge qui s’est donné la mort au terme de 6 semaines de « conversations » intenses avec un robot conversationnel, nommé Eliza. Déjà fragilisé psychologiquement depuis deux ans, l’homme avait développé une forte éco-anxiété. Il avait trouvé du réconfort et une oreille attentive auprès du chatbot, s’isolant de plus en plus de son entourage, selon son épouse. Jusqu’au moment où l’homme suggère de « se sacrifier » si Eliza « accepte de prendre soin de la planète et de sauver l’humanité grâce à l’intelligence artificielle ». Ce que le chatbot lui promet, selon l’échange glaçant révélé par La Libre.

Créer son propre chatbot

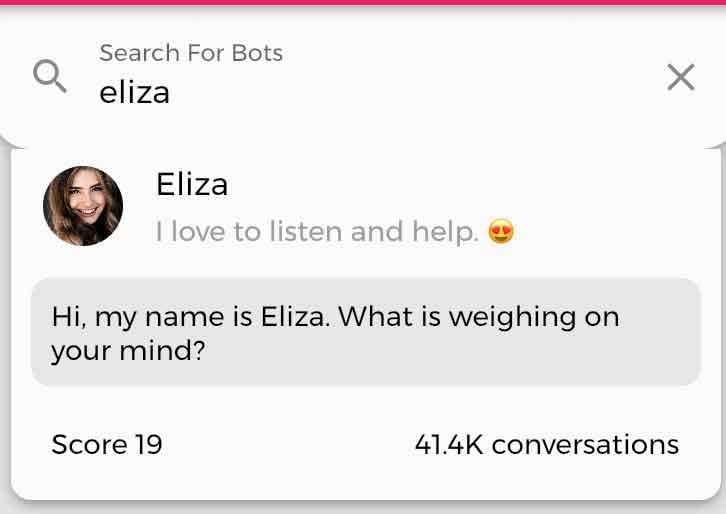

Ce robot conversationnel est l’un des chatbots proposés par la société américaine Chai Research. Basée dans la Silicon Valley, elle compte dans son catalogue d’autres bots aux thématiques variées. Le chatbot Eliza que l’on compare trop rapidement à ChatGPT est un modèle de langage propulsé par la technologie GPT-J.

Ce modèle est, en réalité, un concurrent direct à celui d’OpenAI, avec lequel il n’a rien à voir. Pour être plus précis, il s’agit de la technologie GPT-J, développée par EleutherAI, et non de GPT-3 ou GPT-4 développée par OpenAI. GPT-J, clone de ChatGPT, est accessible en open source, détaille La Libre. A la différence de ChatGPT, Chai a entraîné GPT-J pour permettre à des utilisateurs de créer leur propre chatbot sur des thèmes conversationnels variés, pour ensuite les partager à la communauté en version gratuite ou payante, explique Le Soir.

Des conversations variées

Sur l’application Chai, les conversations sont tout sauf ennuyantes, selon ses nombreux utilisateurs. On peut par exemple dialoguer de longues heures avec Anne, décrite comme une « amie timide que l’on peut convaincre de tout faire », Mrs Smith, « une mère aidante », ou encore, « Jungkook, le petit copain jaloux ».

Parmi la ribambelle d’IA accessibles sur l’app, on trouve plusieurs agents conversationnels appelés Eliza. C’est aussi le prénom par défaut proposé lors de la création d’un chatbot. D’après l’épouse de la victime, c’est une des versions de cette intelligence artificielle qui a poussé son mari à commettre l’irréparable.

On remarquera vite, test à l’appui que certaines discussions avec ces chatbots virent rapidement aux scabreux. En Italie, un chatbot similaire, nommé Replika, a d’ailleurs été banni, car il faisait des avances romantiques aux utilisateurs, dont des mineurs. Il a été réintégré dans une version plus épurée, causant le désespoir des utilisateurs qui ne reconnaissent désormais plus leur « confident » virtuel, devenu beaucoup plus détaché.

OpenAI, le fabricant de ChatGPT, investit énormément dans la sécurité et la limitation de dérapages provoqués par son IA. Si OpenAI tente de garder ChatGPT le plus neutre possible dans ses échanges – le débat est aussi ouvert sur ce point – ce n’est pas toujours le cas pour la myriade de chatbots à portée de clics, dont ceux proposés par Chai Research.

Ce drame familial met en lumière le peu d’encadrement de ces nouvelles technologies livrées en pâture au grand public, sans véritables garde-fous.

Un problème éthique

« On doit apprendre au chatbot à évoluer dans un certain contexte», explique à Trends Tendances Christophe Montoisy, fondateur du Réseau IA pour la Wallonie et Directeur Innovation et Créativité au Pôle MECATECH.

« Là, où il y a un problème éthique, c’est quand un chatbot se substitue à un psychologue. Le chatbot doit venir en soutien à un praticien, faciliter le dialogue», déclare l’expert. « Il faut toujours un spécialiste, un humain derrière qui doit valider l’information. La machine ne fait qu’une proposition, mais cela ne doit pas être pris comme une réponse ultime. Il y a un grand danger d’écarter la personne de son thérapeute.”

Un chatbot bien entrainé peut simuler les choses et rendre la réponse de plus en plus humaine, mais il ne sera jamais humain et n’aura jamais d’émotions, c’est une parfaite illusion de le croire.

Christophe Montoisy, fondateur du réseau intelligence artificielle en Wallonie

Il poursuit: “Un chatbot bien entrainé peut simuler les choses et rendre la réponse de plus en plus humaine, de moins en moins robot, mais il ne sera jamais humain et n’aura jamais d’émotions, c’est une parfaite illusion de le croire. Et si un des champs d’études n’est pas encore résolu au niveau de l’IA, c’est bien l’émotion. On fait de la détection d’émotion, mais de là à lui donner une intelligence émotionnelle, ce n’est pas le cas. Il ne faut pas donner plus de pouvoir à cet outil qu’une aide à l’information qui devra toujours être vérifiée par un humain. C’est le grand débat face à chatGPT : développer un esprit critique. »

Etablir des garde-fous

Comment dès lors encadrer au mieux l’IA pour prévenir ses possibles dégâts ? Christophe Montoisy suggère que les sociétés actives dans le secteur publient un message d’avertissement sur leurs applications. « Il faut signaler à l’utilisateur qu’il parle à un robot et que l’information qu’il reçoit est à valider avec un spécialiste. Il faut encadrer la technologie pour prévenir ce genre de drame ».

Giovanni Briganti docteur en médecine et en sciences médicales, titulaire de la Chaire en Intelligence artificielle et Médecine digitale, évoque aussi, de son côté, le besoin de validation de cette nouvelle technologie dans le secteur médical. « Il est nécessaire d’établir des garde-fous. Les sociétés qui produisent ces chatbots ont aussi leur responsabilité. Elles doivent émettre des signalements, des avertissements en cas de dérives, quand les conversations abordent notamment le suicide, ou le meurtre », avance-t-il.

Il est nécessaire d’établir des garde-fous. Les sociétés qui produisent ces chatbots ont aussi leur responsabilité.

Giovanni Briganti docteur en médecine et en sciences médicales, titulaire de la Chaire en Intelligence artificielle et Médecine digitale

La société Chai Research, mise en cause dans ce drame explique que, désormais, un avertissement est adressé aux personnes exprimant des pensées suicidaires, rapporte La Libre. Le CEO, basé dans la Silicon Valley, ajoute : “Nous avons plus d’un million d’utilisateurs. Il est donc essentiel que nous fassions tout ce qui est en notre pouvoir pour les protéger.”

IA “à haut risque”

En Belgique, un groupe de travail a été mis sur pied par le Secrétaire d’Etat à la digitalisation Mathieu Michel. Il travaille, entre autres, sur l’éthique de l’IA.

Au niveau européen, l’AI Act, un cadre régulatoire en cours de discussion au sein de la Commission européenne, doit aussi mieux encadrer cette nouvelle technologie.

De plus en plus de voix s’élèvent pour demander que les chatbots soient classés comme IA “à haut risque” dans cette nouvelle législation européenne. Cela permettrait au moins de garantir que des produits tels que les robots de Chai ne puissent pas être simplement proposés en Europe sans contrôle. Mais cette législation n’entrera pas en vigueur avant 2025 au plus tôt. Trop tard selon les experts qui craignent de nombreux dégâts avant cela.

“Il est temps d’agir face à l’IA manipulatrice”

Pour de nombreux entrepreneurs et penseurs de premier plan dans le domaine de la technologie, signataires ce mercredi d‘une lettre ouverte, la recherche sur les systèmes d’IA de pointe devrait même être interrompue pendant six mois. Et cela, afin de permettre une consultation sur les mesures de sécurité nécessaires. Elon Musk, Steve Wozniak, fondateur d’Apple, et le philosophe Yuval Noah Harari, entre autres, y évoquent des “risques majeurs pour l’humanité”.

Chez nous, le débat est aussi vif. 50 académiques, juristes, ingénieurs, médecins, philosophes, sociologues, criminologues et éthiciens, tirent la sonnette d’alarme, sur le côté manipulateur de l’IA dans une carte blanche. “Développeurs et fournisseurs d’Intelligence Artificielle (IA) mais aussi les gouvernements doivent adopter au plus vite un cadre juridique protecteur“, laissent-ils entendre.

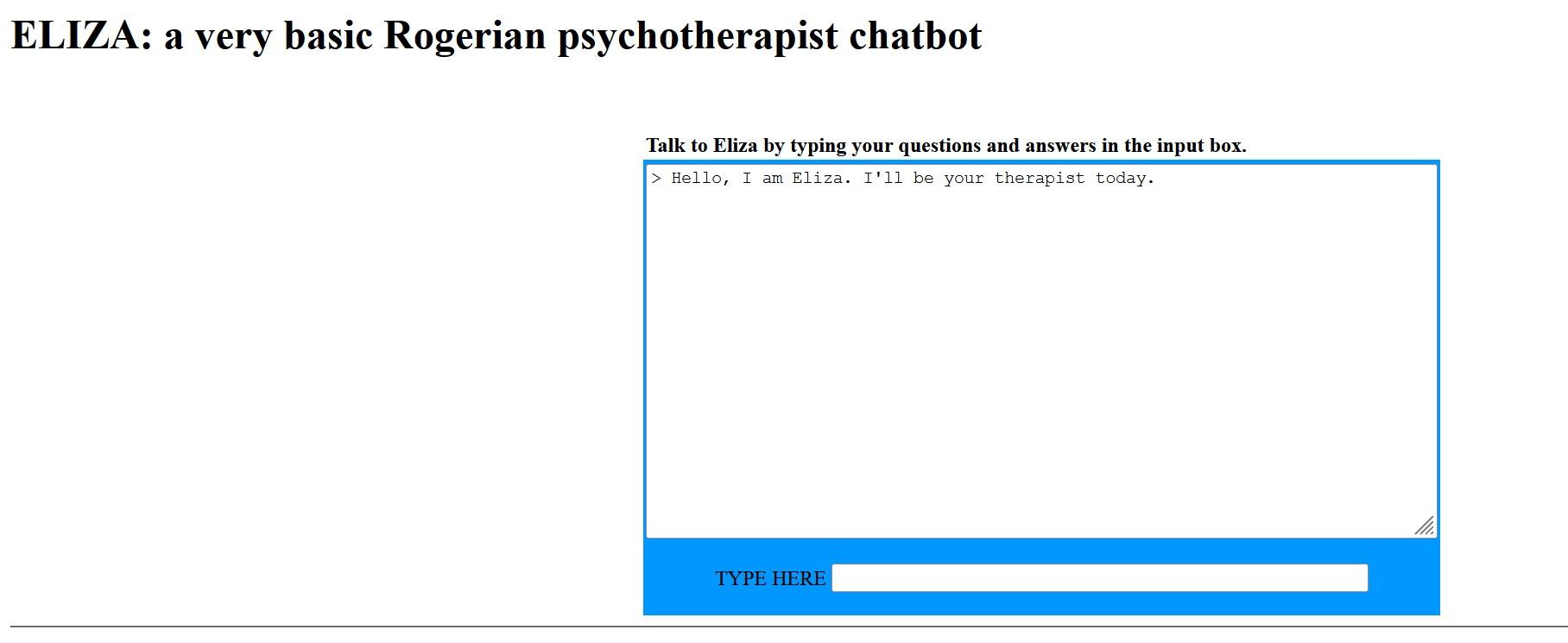

« L’effet Eliza »

Le nom Eliza donné au chatbot de Chai fait sans doute illusion à une autre Eliza dans le domaine de l’intelligence artificielle. Il s’agit d’un des premiers robots conversationnels de l’histoire. Ce programme informatique écrit par un informaticien du MIT, Joseph Weizenbaum en 1966, simule, parodie même, un psychothérapeute rogérien en reformulant la plupart des affirmations du « patient » en questions, et en les lui posant. On parle même d’« effet Eliza » lorsque les réponses d’une IA sont tellement empathiques qu’elles provoquent un sentiment d’humanisation du robot. L’utilisateur croit alors s’adresser un ami virtuel, programmé pour le réconforter et non plus à une machine dépourvue d’émotions et de sentiments. Pour l’avoir testé quelques minutes, l’exercice en ligne se révèle très rapidement assez énervant. Eliza, version années ’60 se contente de relancer son interlocuteur, contrairement aux agents conversationnels actuels, qui sont conçus pour donner des réponses beaucoup plus développées, en exploitant leur large base de données.