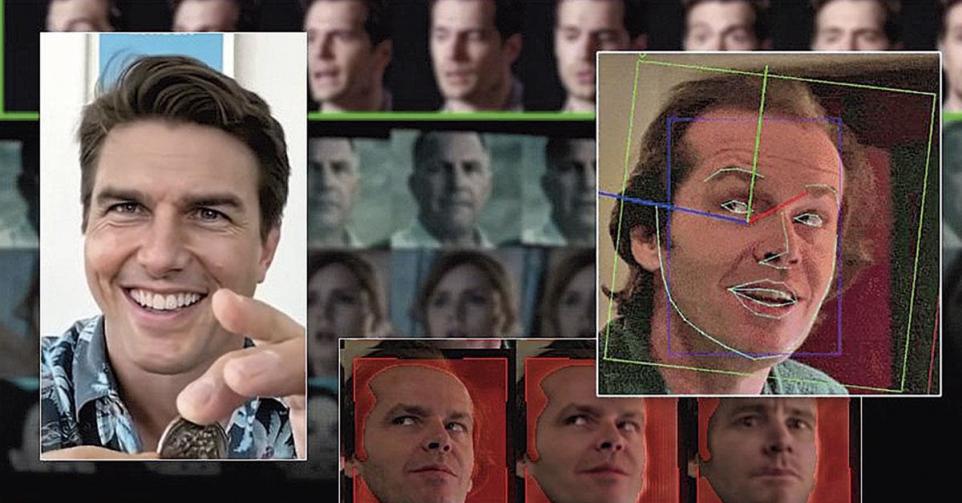

Les “deepfakes” menacent également les entreprises

Source: Trends-Tendances

5 min. de lecture

Vous avez repéré une erreur ou disposez de plus d’infos? Signalez-le ici