Comment pouvons-nous alors garantir que l’IA continue à fournir des réponses fiables ?

L’IA générative devient rapidement un outil incontournable dans les entreprises. Maintenant que le battage médiatique initial s’estompe et que l’IA devient l’un des nombreux outils à notre disposition, un point moins connu fait son apparition : depuis 2021, il est de plus en plus difficile de savoir si les informations utilisées pour entraîner les modèles sont encore vraiment humaines. Comment pouvons-nous alors garantir que l’IA continue à fournir des réponses fiables ?

Une étude internationale de KPMG révèle que plus de quatre professionnels sur cinq considèrent les résultats inexacts comme un risque majeur. Elsevier rapporte que 94 % des chercheurs craignent que la désinformation devienne un défi permanent. Et selon le Reuters Institute, de plus en plus de lecteurs déclarent avoir moins confiance dans les informations générées par l’IA. À une époque où personne ne sait plus vraiment ce qui est vrai et ce qui est faux, c’est justement là que réside l’opportunité : ceux qui choisissent délibérément des données traçables et diversifiées tirent non seulement parti de la rapidité de l’IA, mais aussi de sa fiabilité.

L’IA apprend de plus en plus d’elle-même

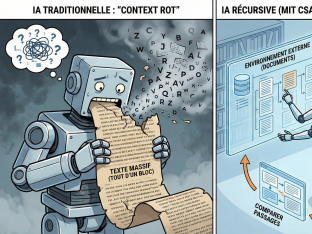

Jusqu’en 2021, lors du lancement de DALL-E par OpenAI, nous entraînions principalement les modèles d’IA avec des apports humains : textes de journalistes, données issues de sources fiables ou photos de photographes. Depuis l’avènement de l’IA générative, cet équilibre a changé. De plus en plus souvent, les réponses et résultats d’un modèle se retrouvent dans le jeu de données d’entraînement du suivant. Cela crée une réaction en chaîne : l’IA apprend de l’IA, au lieu d’apprendre de la réalité.

On peut comparer cela à une feuille de papier que l’on passe plusieurs fois dans une photocopieuse : chaque copie devient un peu plus floue. Dans le monde de l’IA, on appelle cela le « model collapse » : après quelques générations, un modèle perd son ancrage dans la réalité. Les erreurs s’accumulent, les écarts deviennent la norme, et ce qui reste est de moins en moins exploitable.

Données suspectes : la chambre d’écho numérique

Aujourd’hui, une grande partie de l’entraînement des IA se fait avec ce que les spécialistes appellent des « données suspectes » : des données dont on ne sait plus si elles sont d’origine humaine ou déjà générées plusieurs fois par d’autres modèles. Le risque ? L’IA devient prévisible, fournit moins d’idées originales et peut même commettre des erreurs cruciales. Pensez à un modèle médical qui ne reconnaît plus une maladie rare parce qu’elle a disparu du jeu de données.

De plus, la plupart des modèles d’IA fonctionnent comme une boîte noire : on obtient bien une réponse, mais on ne sait presque jamais pourquoi. Cela devient dangereux si les données sous-jacentes sont polluées. Surtout dans des secteurs comme la santé ou la finance, cela peut mener à de mauvaises décisions aux conséquences graves.

Comment conserver la valeur de l’IA

La solution ne réside pas dans la quantité de données, mais dans leur qualité. Les entreprises doivent gérer leurs sources de manière plus intelligente.

- Utilisez des apports humains et des données originales dont vous connaissez la provenance.

- Variez les données d’entraînement : combinez textes, chiffres, audio ou autres formats.

- Évitez que les modèles apprennent automatiquement de leur propre production.

- Intégrez des boucles de rétroaction où l’humain intervient, et mettez en place des systèmes de détection pour repérer la réutilisation.

- Faites la différence entre l’entraînement et le prompt : le cœur du modèle est défini par les données d’entraînement. Les prompts donnent du contexte, mais ne changent pas la base.

Une méfiance raisonnée est un atout

L’avenir de l’IA ne dépend pas de qui collecte le plus de données, mais de qui choisit les bonnes. Les entreprises qui font aveuglément confiance à tout ce qui est disponible en ligne risquent de se retrouver piégées dans une chambre d’écho numérique. Celles qui investissent avec une méfiance raisonnée dans des données fiables gardent le contrôle et tirent une véritable valeur ajoutée de l’IA.

Par Steven Peirsman, Business Unit Leader Data & AI chez Inetum Belgique