Ce 2 août marque une étape cruciale dans l’entrée en vigueur de l’AI Act. La législation européenne sur l’intelligence artificielle cible désormais les modèles dits “à usage général”, utilisés pour générer du texte, des images ou du code. Une régulation sans précédent qui vise les poids lourds du secteur.

Le règlement sur l’intelligence artificielle de l’Union européenne atteint une nouvelle étape. Ce 2 août, ce sont les systèmes dits “General Purpose AI” (GPAI), ou intelligences artificielles à usage général, qui doivent désormais respecter tout un éventail d’exigences.

Sous cette appellation, l’UE regroupe les modèles d’IA conçus pour exécuter une grande variété de tâches : rédaction de textes, génération d’images, résolution de problèmes mathématiques, création de code ou encore recherche documentaire. Et qui, en raison de leur puissance et de leur polyvalence, sont utilisés comme base pour de nombreux outils d’IA et qui représentent, de ce fait, un risque systémique pour Bruxelles.

L’Union européenne impose désormais aux développeurs et fournisseurs de GPAI une série d’exigences strictes : transparence sur le fonctionnement des modèles, respect du droit d’auteur, et dossiers techniques détaillés sur la manière dont les systèmes sont conçus, testés et utilisés.

L’objectif ? Garantir que ces outils puissants n’échappent pas aux principes fondamentaux de l’Union, en particulier la protection des droits fondamentaux et la sécurité des citoyens. Pour les modèles les plus à même d’avoir un impact significatif sur la société, les libertés publiques ou la santé, l’AI Act leur impose de se soumettre à des évaluations renforcées des risques systémiques.

Le Code de bonne conduite fait débat

Pour accompagner cette transition, le Bureau européen de l’IA, récemment créé, a publié un Code de bonnes pratiques GPAI à destination des acteurs du secteur. Il s’agit d’un cadre volontaire, mais qui préfigure les obligations futures une fois le règlement pleinement effectif.

Des géants comme Google et OpenAI ont annoncé leur volonté de signer ce code. En revanche, Meta a clairement exprimé son refus, critiquant la position trop contraignante de l’Union européenne vis-à-vis de l’intelligence artificielle. L’empire Zuckerberg assure que cela va avoir un effet négatif sur le développement et l’adoption de cette technologie au sein de l’UE.

L’AI Act, de quoi s’agit-il ?

Cette nouvelle étape du déploiement de l’AI Act offre l’occasion de revenir sur ce cadre législatif, le premier du genre au niveau mondial. Entré officiellement en vigueur le 1er août 2024, il a d’abord introduit une série d’obligations et d’interdictions ciblant notamment les systèmes d’IA contraires aux valeurs fondamentales de l’Union européenne. Une seconde phase, entrée en application en février dernier, a interdit les systèmes présentant un risque jugé “inacceptable”, selon la classification établie par Bruxelles. Mais en quoi consiste précisément l’AI Act ?

“Toutes les mesures prévues par l’AI Act visent à garantir la sécurité, les droits fondamentaux et une IA centrée sur l’humain, et renforcent l’adoption, l’investissement et l’innovation dans l’IA dans toute l’UE”, peut-on lire sur le site de l’Union européenne. En d’autres termes, le règlement de l’UE vise à mettre les intérêts humains au centre de l’attention dans le développement de l’IA.

C’est dans ce but que le règlement a été développé, afin de s’assurer que les développeurs et déployeurs d’IA construisent des outils fiables, répondant à des exigences spécifiques en fonction des risques liés aux systèmes développés et à leurs usages spécifiques. Un positionnement très éloigné de celui du cadre législatif récemment présenté par Donald Trump et qui peut se résumer par : dérégulation.

L’AI Act s’applique à toutes les organisations, grandes ou petites, qui développent ou utilisent des systèmes d’IA en Europe. Par ailleurs, il s’applique autant pour les entreprises européennes que pour celles hors UE, du moment qu’elles proposent leurs services sur le marché européen.

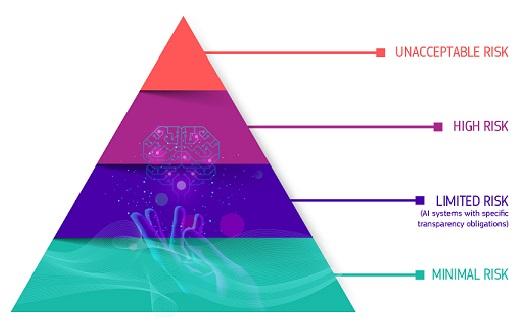

Quatre niveaux de risque, quatre niveaux d’exigence

L’Union européenne a classé les systèmes d’intelligence artificielle en fonction des risques qu’ils représentaient selon leur utilisation prévue. Pour chaque niveau de risque correspond un certain nombre d’obligations pour les développeurs et fournisseurs de ces systèmes d’IA.

- Risque minimal ou nul

Aucune obligation particulière. Cela concerne par exemple les filtres anti-spam ou les IA utilisées dans les jeux vidéo.

- Risque limité

Les IA génératives comme ChatGPT ou Gemini doivent signaler clairement leur nature, et leurs contenus doivent être identifiables (deepfakes, textes à visée informative…), afin d’éviter toute confusion de la part des utilisateurs.

- Risque élevé

Tout système d’IA déployé dans un domaine susceptible d’avoir un impact majeur sur la santé, la sécurité ou les droits fondamentaux est automatiquement classé comme à “risque élevé”. Des secteurs tels que l’éducation, la santé, la justice, l’emploi ou encore la surveillance biométrique sont considérés comme particulièrement sensibles. À ce titre, ils impliquent des obligations renforcées en matière de sécurité : robustesse technique, prévention des biais, traçabilité, transparence documentaire et supervision humaine obligatoire.

- Risque inacceptable

Huit pratiques d’IA sont interdites dans l’UE, dont la manipulation, la notation sociale, l’exploitation de vulnérabilités, la police prédictive, la reconnaissance faciale à distance en temps réel, la détection des émotions à l’école ou au travail, la catégorisation biométrique visant à déduire des caractéristiques sensibles et la constitution illégale de bases de données destinées à la reconnaissance faciale.

Une surveillance et des amendes salées

Un Bureau européen de l’IA est en charge de vérifier le respect des règles de l’AI Act. Les entreprises qui ne respecteraient pas le règlement s’exposent à des sanctions particulièrement sévères : jusqu’à 35 millions d’euros d’amende ou 7 % du chiffre d’affaires mondial, selon la gravité de la violation.

Avec l’entrée en vigueur des règles relatives aux GPAI, faut-il s’attendre à une vague de sanctions dès le 3 août ? Peu probable. Bien que l’Union européenne ait réaffirmé son intention de maintenir le calendrier qu’elle s’est elle-même fixé, malgré les critiques et pressions des géants du secteur, il est raisonnable de penser qu’elle fera preuve de pragmatisme. Tant que les acteurs concernés démontrent leur bonne foi et s’engagent activement dans une démarche de mise en conformité, Bruxelles pourrait adopter une période de tolérance, à l’image de ce qui avait été observé en 2018 lors de l’entrée en vigueur du RGPD.