Dix mois après le lancement en fanfare de ChatGPT, la révolution de l’intelligence artificielle (IA) s’est accélérée mais elle fait face à ses premiers obstacles, comme les forts besoins des start-up du secteur en composants électroniques.

Car sans un certain type de semi-conducteurs, les cartes graphiques (ou GPU en anglais), difficile de développer des modèles d’IA générative. Une seule entreprise produit actuellement des composants de ce type suffisamment puissants pour cette technologie : Nvidia.

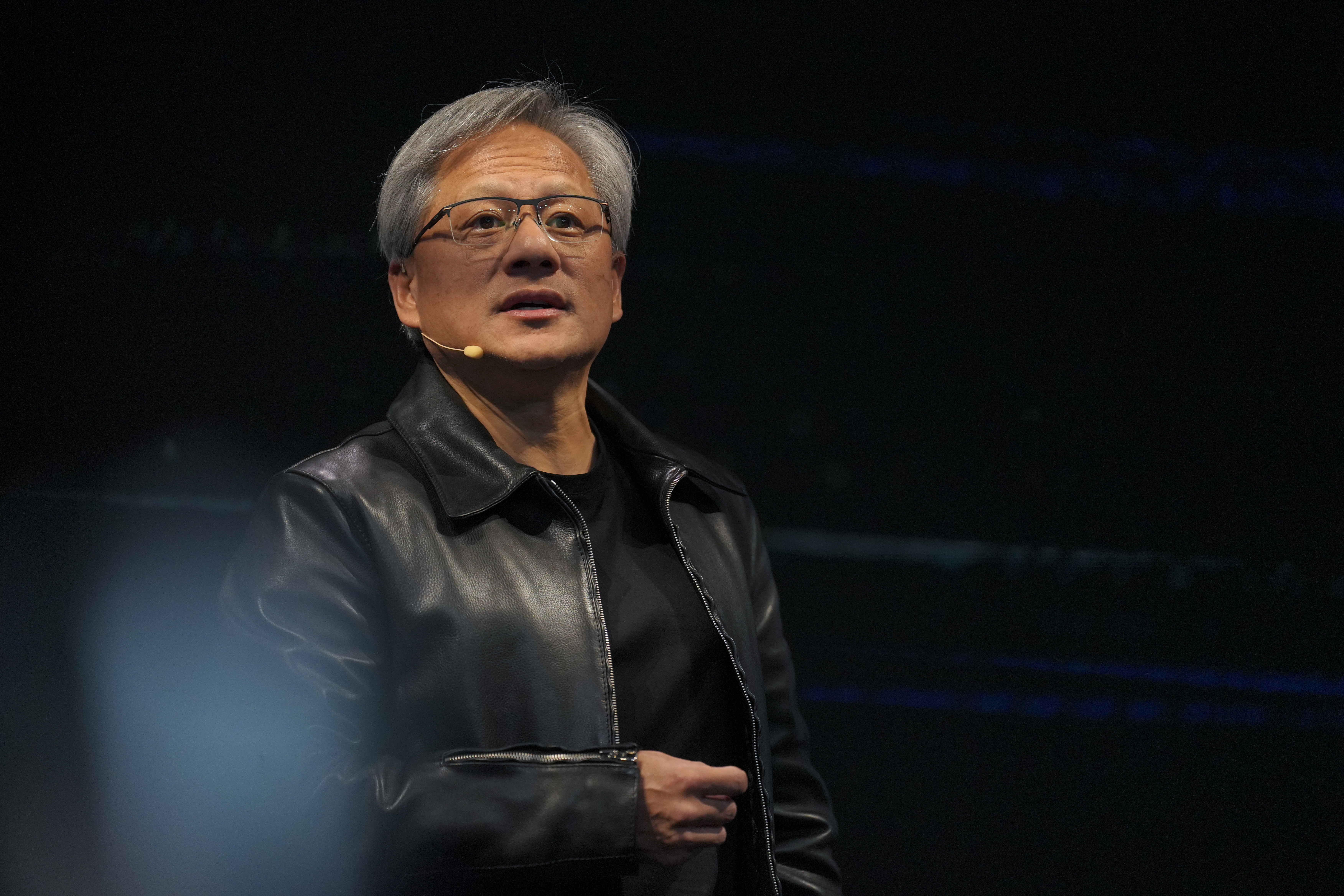

Le fondateur et patron de l’entreprise américaine, Jensen Huang, a parié il y a des années sur ces processeurs prisés des développeurs de jeux vidéo, persuadé que, tôt ou tard, le monde en aurait besoin pour l’IA. Et il a remporté son pari: aujourd’hui, aucune entreprise ne peut mettre au point de systèmes d’IA générative sans s’appuyer sur les GPU de Nvidia, tout particulièrement sa puce H100 et les logiciels associés.

Une dure réalité pour la concurrence, d’Amazon à Intel en passant par un autre champion des ordinateurs pour les jeux vidéo, AMD, qui cherchent depuis à combler leur retard. Le rattrapage va prendre plusieurs années. Cette situation n’est pas évidente non plus pour les petites entreprises qui doivent faire preuve d’imagination pour avoir accès à ces précieux composants. “Il devient compliqué de mettre la main sur des milliers de GPU car les géants de la tech déversent des milliards de dollars pour en stocker”, constate Fangbo Tao, cofondateur de Mindverse.AI, une jeune pousse singapourienne. “Il ne reste pas beaucoup de puces disponibles”.

Perquisition en France dans le secteur des cartes graphiques

Une perquisition a été menée cette semaine en France chez un groupe présent dans le secteur des cartes graphiques suspecté de pratiques anticoncurrentielles, a fait savoir l’autorité de la concurrence dans un communiqué, sans nommer l’entreprise concernée. “A ce stade, cette intervention ne préjuge bien évidemment pas de la culpabilité de l’entreprise concernée par les pratiques présumées, que seule une instruction au fond permettra le cas échéant d’établir”, souligne mercredi l’autorité française dans son communiqué.

Cette opération “de visite et de saisie inopinée” a eu lieu mardi et a visé, selon le magazine français Challenges, le géant américain des cartes graphiques Nvidia, installé à l’ouest de Paris et près de Nice. Interrogé jeudi par l’AFP, Nvidia a refusé de commenter.

La production de l’écrasante majorité des semi-conducteurs utilisés pour l’entraînement de modèles d’IA dans le monde dépend de deux entreprises, Nvidia pour la conception, et le Taïwanais TSMC pour la fabrication.

La perquisition a été effectuée “après autorisation d’un juge des libertés et de la détention”, souligne l’antitrust français, qui avait averti fin juin des risques de pratiques anticoncurrentielles dans le secteur du cloud (hébergement de données accessibles à distance), à l’heure du développement à grande vitesse de l’intelligence artificielle.

Au deuxième trimestre, les ventes de Nvidia aux entreprises du cloud ont dépassé les 10 milliards de dollars (+ 171% sur un an), selon les résultats publiés fin août.

Le prix à payer

ChatGPT a débarqué sur les écrans au moment où la Silicon Valley sortait d’une année 2022 noire, marquée par le contrecoup de la pandémie, la baisse des investissements et les vagues de licenciements. Le succès foudroyant de cette nouvelle IA a revigoré tout le secteur du numérique. Les start-up qui se lancent dans l’IA générative sont très bien accueillies par les investisseurs.

Mais les fonds ainsi récoltés partent aussitôt dans les poches de Nvidia ou de services de cloud (informatique à distance). “On fait appel à beaucoup de grands fournisseurs de cloud (Microsoft, AWS et Google, NDLR) et ils nous disent qu’ils ont du mal à se fournir”, souligne Laurent Daudet, PDG de LightOn, une startup qui crée des modèles de langage.

Le problème est particulièrement épineux pour celles qui veulent entraîner leurs propres modèles d’IA générative, la phase de création la plus gourmande en puissance de calcul, car elle nécessite de traiter des montagnes de données récoltées en ligne. Seules quelques entreprises ont donc les moyens de développer de grand modèles de langage généralistes. L’investissement de dix milliards de dollars de Microsoft dans OpenAI est d’ailleurs largement considéré comme le prix à payer pour construire les serveurs nécessaires, alimentés par des GPU de Nvidia bien sûr.

“Marché asséché”

Google construit ses propres modèles et lundi, c’était au tour d’Amazon d’annoncer le versement de quatre milliards de dollars à Anthropic AI, une autre startup d’IA générative, concurrente d’OpenAI.

L’entraînement des modèles “est en train de quasi totalement assécher le marché des GPU”, regrette Said Ouissal, patron de Zededa, une entreprise qui cherche à réduire la consommation d’énergie de l’IA. “Actuellement, vous devez attendre le milieu ou même la fin de l’année prochaine pour être livrés si vous passez commande. Et la pénurie ne semble pas prête d’être réglée”, renchérit Wes Cummins, directeur général d’Applied Digital, spécialisée dans les infrastructures IA.

Les acteurs soulignent également que le rôle essentiel de Nvidia dans l’écosystème place le groupe, de fait, en faiseur de roi quant à l’avenir de l’IA. Le marché est “quasi totalement aux mains des géants du secteur, Google, Amazon, Meta”, qui disposent de “quantités énormes de données et de capital” pour acheter les puces de Nvidia et ainsi développer de l’IA à grande échelle, estimait Jacopo Pantaleoni, ancien ingénieur de Nvidia, dans une interview accordée à The Information. “Ce n’est pas le monde que je voulais construire”, ajoutait-il.

De l’avis de certains vieux connaisseurs de la Silicon Valley, la frénésie autour des GPU de Nvidia ne va toutefois pas durer éternellement et d’autres options vont finir par apparaître. Sans cela, le coût d’entrée sur le marché de l’IA risque de devenir hors de prix, même pour les géants du numérique.