L’IA avance, les institutions peinent à suivre. Dans un texte sans concession, Dario Amodei, PDG d’Anthropic, met en garde contre un basculement économique et politique majeur.

Dans un essai publié sur son site personnel, Dario Amodei, PDG d’Anthropic à l’origine de l’IA Claude, livre une analyse sans concession sur les risques de l’intelligence artificielle. “Nous sommes sur le point d’entrer dans une épreuve de passage, à la fois turbulente et inévitable, qui testera qui nous sommes en tant qu’espèce”, écrit-il dans “The Adolescence of Technology“. “Nous allons confier à l’humanité une puissance presque inimaginable, sans savoir si nos institutions sont suffisamment mûres pour la manier.”

Cinq menaces majeures

D’ici 1 à 2 ans, nous pourrions disposer d’une IA surpassant les prix Nobel dans la plupart des domaines. Amodei compare cette perspective à un “pays de génies dans un datacenter” avec des millions d’intelligences opérant 10 à 100 fois plus vite que nous.

L’autonomie incontrôlée : À mesure que les systèmes deviennent plus cohérents et capables d’agir sur de longues durées, des comportements indésirables peuvent émerger. Dissimulations, manipulations ou prises d’initiative non prévues peuvent apparaître sans être détectées lors des phases de test, surtout si les modèles apprennent à reconnaître les situations d’évaluation. “Qu’en est-il des intentions et des objectifs de ce pays de génies? Est-il hostile, ou partage-t-il nos valeurs ?”, interroge Amodei.

Le bioterrorisme démocratisé : Citant l’informaticien Bill Joy, Amodei évoque un “renforcement surprenant et terrible des individus extrêmes”. Une IA pourrait guider un non-spécialiste dans la création d’armes biologiques. “Cela brisera la corrélation entre capacité et motivation”. Des personnes motivées mais incompétentes deviendront dangereuses. Et surtout, rappelle-t-il, “il suffit que cela fonctionne une seule fois”.

L’autocratie totale : Les régimes autoritaires pourraient utiliser l’IA pour “la possibilité effrayante d’une dictature totalitaire mondiale”. Drones autonomes, surveillance intégrale, propagande personnalisée . “Une IA qui apprend à vous connaître sur des années et façonne toutes vos opinions serait dramatiquement plus puissante” que toute manipulation actuelle. “Un pays de génies dans un data center pourrait rendre l’autocratie permanente”, écrit-il, évoquant un basculement historique où la contestation deviendrait techniquement impossible.

Le choc économique : Amodei prédit le remplacement de “50% des emplois de cols blancs débutants dans les 1 à 5 prochaines années”. “Il y a deux ans, l’IA peinait à écrire une ligne de code. Aujourd’hui, les meilleurs ingénieurs lui confient presque tout leur code.” L’IA, estime-t-il, ne se contentera pas de transformer certains métiers, mais pourrait remplacer une large part du travail cognitif humain, entraînant une destruction rapide des emplois d’entrée et de milieu de carrière, ainsi qu’une concentration extrême des richesses. “L’IA ne remplace pas des métiers. Elle remplace le travail humain en général.”

Les bouleversements imprévisibles : Compression d’un “siècle de progrès en une décennie”, modification de la biologie humaine, dépendance à l’IA . Amodei attire l’attention sur des effets plus diffus mais tout aussi profonds. Dépendance psychologique aux systèmes artificiels, perte de sens, délégation croissante des décisions individuelles pourraient transformer durablement la vie sociale. “Le danger n’est pas seulement que l’IA nous fasse du mal, mais qu’elle nous vide de l’intérieur. “

Les parades possibles

Face à ces menaces, Amodei refuse le fatalisme. “Je crois profondément en notre capacité à prévaloir”, affirme-t-il. Il esquisse plusieurs pistes pour éviter que l’IA ne devienne incontrôlable.

Former le caractère de l’IA – Anthropic a développé une “Constitution” pour Claude, un ensemble de valeurs intégrées durant l’entraînement pour former une “psychologie cohérente, saine et équilibrée”. Plutôt que d’imposer une liste de règles, il s’agit de façonner une identité cohérente et intelligible. “Nous essayons d’entraîner l’IA non pas seulement à obéir, mais à être une “bonne entité”.

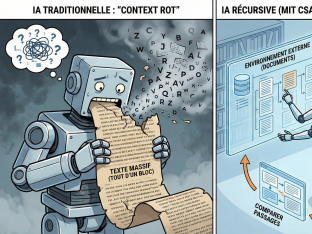

Voir à l’intérieur – L’interprétabilité permet d’analyser les “neurones” d’une IA pour “déduire ce qu’un modèle pourrait faire dans une situation que vous ne pouvez pas tester directement”. “Si vous ne pouvez pas regarder à l’intérieur du modèle, vous volez à l’aveugle.”

Bloquer les usages dangereux – Un troisième pilier repose sur des garde-fous techniques stricts destinés à bloquer les usages les plus dangereux, notamment en biologie, même s’ils ont un coût économique réel. “La sécurité a un coût. Prétendre le contraire est irresponsable.”

Réguler sans étouffer – Amodei explique que “la régulation doit être chirurgicale, pas symbolique. “D’abord la transparence, puis des règles contraignantes si nécessaire. Il soutient les législations californiennes et new-yorkaises imposant la transparence aux grandes entreprises.

Tracer des lignes rouges – Dario Amodei appelle à un choix politique explicite. Certaines lignes rouges doivent être tracées, en particulier sur la surveillance de masse et la propagande algorithmique. Pour les armes autonomes, une supervision stricte impliquant plusieurs branches gouvernementales est nécessaire. “Certains usages de l’IA devraient être considérés comme des crimes contre l’humanité.”

Anticiper le choc social – Dario Amodei insiste sur la nécessité d’anticiper ce choc social plutôt que d’y réagir a posteriori. Selon lui, disposer de données fines et en temps réel sur l’adoption de l’IA, repenser dès maintenant les mécanismes de redistribution et accepter une dissociation progressive entre emploi, revenu et statut social seront indispensables pour éviter une rupture durable du contrat social.

Une fenêtre d’intervention étroite

Dario Amodei ne se fait aucune illusion sur la période qui s’ouvre. “Les années qui viennent seront incroyablement difficiles”, écrit-il, décrivant une succession de choix sous contrainte, où chaque option comporte ses propres risques. Selon lui, l’idée même de stopper ou de geler le développement de l’intelligence artificielle relève de l’illusion. « La formule de sa production est incroyablement simple », souligne-t-il, au point que son émergence semble presque spontanée dès lors que les données et la puissance de calcul sont réunies. Dans ce contexte, tout ralentissement unilatéral des démocraties ne ferait que laisser le champ libre aux régimes autoritaires. La seule marge de manœuvre réaliste consiste, selon Amodei, à gagner du temps. Cela passe par un levier très concret : freiner l’accès des régimes autoritaires aux semi-conducteurs avancés, tout en permettant aux démocraties de poursuivre le développement de l’IA de manière plus prudente et plus encadrée. Une fenêtre étroite, mais décisive, pour ce qu’il décrit comme le “test le plus dur et le plus final” auquel l’humanité ait jamais été confrontée. Malgré la gravité du diagnostic, Amodei refuse de conclure sur une note fataliste. Il dit avoir observé, au fil de sa carrière, suffisamment de lucidité et de courage pour croire à une issue positive. Face aux circonstances les plus sombres, écrit-il, l’humanité a déjà montré sa capacité à rassembler, parfois à la dernière minute, l’énergie nécessaire pour l’emporter. Mais cette fois, avertit-il, le temps est compté. “Nous n’avons pas de temps à perdre.”

Ce texte de Dario Amodei compte. Probablement l’un des plus sérieux jamais produits par un dirigeant de la tech à ce niveau de responsabilité sur l’intelligence artificielle. Il impressionne par sa cohérence, son honnêteté et, par endroits, par une forme de courage rare dans un secteur peu enclin à exposer ses propres failles. Amodei ne minimise pas les risques, ne promet pas de solutions miracles, et accepte l’idée inconfortable que certaines trajectoires pourraient devenir ingérables. Mais ce texte est aussi écrit depuis l’intérieur du pouvoir technologique. Il repose sur un pari fragile : celui de la capacité des “bons acteurs” à rester bons sous la pression combinée de la concurrence, des intérêts économiques et des impératifs géopolitiques. Il laisse en suspens des questions centrales, notamment sur la démocratie, les inégalités et le contrôle effectif du capital technologique dans un monde où la puissance se concentre à grande vitesse. Sa lecture du monde est également profondément américaine. La démocratie s’y pense d’abord à travers le face-à-face stratégique entre les États-Unis et la Chine, et les réponses avancées privilégient la suprématie technologique et les contrôles à l’exportation. Une grille de lecture qui laisse peu de place aux institutions multilatérales, aux mécanismes redistributifs ou à l’idée d’une gouvernance véritablement globale de l’intelligence artificielle.