Le Recursive Language Model (RLL) développé par des chercheurs du MIT promettent une IA qui lit moins mais comprend mieux.

Ces dernières années, l’intelligence artificielle générative a progressé selon une logique simple. Des modèles toujours plus grands, capables d’ingérer toujours plus de texte. Mais cette course à la taille se heurte à une limite bien connue des chercheurs comme des utilisateurs. Au-delà d’un certain volume, l’IA lit mal, se perd et commence à halluciner.

C’est à cette impasse que s’attaque une équipe de chercheurs du MIT, au sein du laboratoire CSAIL, le Computer Science and Artificial Intelligence Laboratory. Leur proposition porte un nom technique, Recursive Language Models (RLL), ou modèles de langage récursifs. Elle repose sur une intuition très concrète, arrêter de forcer les modèles à tout lire d’un bloc.

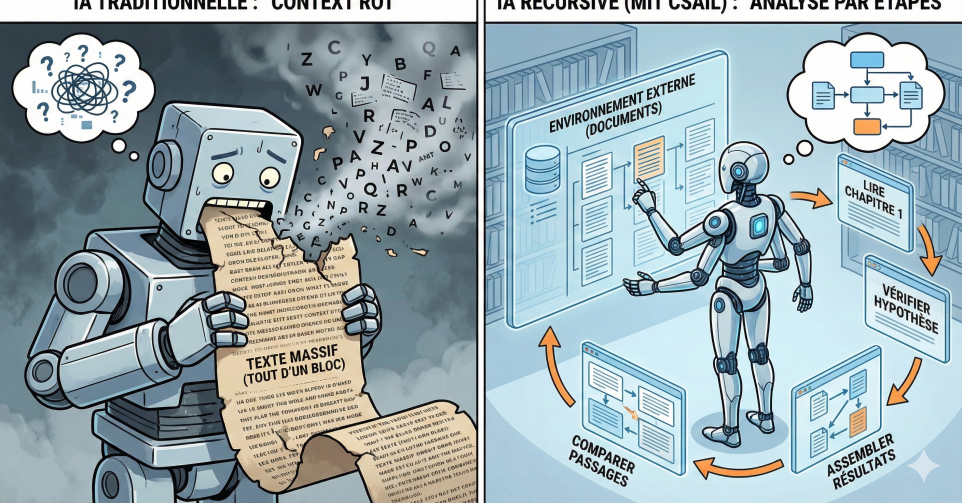

Actuellement, les modèles de langage fonctionnent avec une fenêtre de contexte limitée et plus on leur fournit de texte, plus la compréhension se dégrade. Les oublis se multiplient, les confusions apparaissent, le raisonnement devient approximatif. Les chercheurs parlent de context rot, une forme d’usure cognitive de la machine. Dans le monde économique, cette limite est lourde de conséquences. Les documents stratégiques, qu’il s’agisse de rapports financiers, de bases réglementaires, de contrats ou d’historiques clients, sont rarement courts. Pour les rendre exploitables par une IA classique, on a souvent recours au résumé. Un choix pratique, mais coûteux, car résumer, c’est déjà perdre de l’information.

L’innovation des modèles récursifs tient à un changement de perspective. Plutôt que d’injecter tout le texte dans le modèle, les chercheurs proposent de placer le document dans un environnement externe, accessible à l’IA. Le texte n’est plus une simple entrée, il devient un espace dans lequel le modèle peut circuler.

Pour comprendre la différence, il faut imaginer un livre de mille pages. Une IA classique tente de lire l’ensemble du livre en une seule fois, puis d’en produire un résumé global. Plus le livre est long, plus la compréhension se dégrade. Une IA récursive procède autrement. Elle lit un chapitre, en extrait les éléments utiles, puis passe au suivant. Mais surtout, elle peut revenir à un chapitre déjà lu, comparer deux passages éloignés, vérifier une hypothèse, et réexaminer une section précise si nécessaire. En sorte, elle construit sa compréhension progressivement, comme le ferait un lecteur humain travaillant sur un texte complexe.

Une IA qui apprend à travailler dans la durée

Les résultats expérimentaux montrent que cette approche permet de traiter des volumes de texte bien supérieurs aux limites habituelles, tout en améliorant la qualité du raisonnement sur des tâches complexes. Et surtout, sans nécessiter de modèles plus lourds ou plus coûteux. Pour les entreprises, l’enjeu est stratégique. Une IA capable de travailler efficacement sur de vastes corpus réglementaires, financiers ou techniques ouvre de nouveaux usages en audit, conformité, veille stratégique ou ingénierie logicielle.

Un autre avantage mérite l’attention. Comme l’IA agit par étapes, en recherchant, filtrant et vérifiant, il devient plus facile de comprendre comment une réponse a été construite. Dans un contexte où la confiance et la responsabilité sont centrales, cette traçabilité partielle est un gain.

Les modèles récursifs ne promettent pas des réponses plus spectaculaires ou plus créatives. Leur ambition est ailleurs. Mieux lire pour mieux décider. Moins d’effets de démonstration, plus de solidité sur des problèmes longs, complexes et coûteux à analyser humainement. En ce sens, l’approche développée par les chercheurs du MIT marque peut-être un tournant discret mais décisif. Une intelligence artificielle qui ne cherche plus à tout savoir immédiatement, mais qui apprend à travailler dans la durée, à l’image des personnes qu’elle est censée assister.