Les “deepfakes” menacent également les entreprises

Propulsés par des algorithmes quasi autonomes, les “deepfakes” (hypertrucages) ont gagné en réalisme, sophistication et démocratisation. Une énième menace cyber à prendre sérieusement en compte, y compris pour les entreprises.

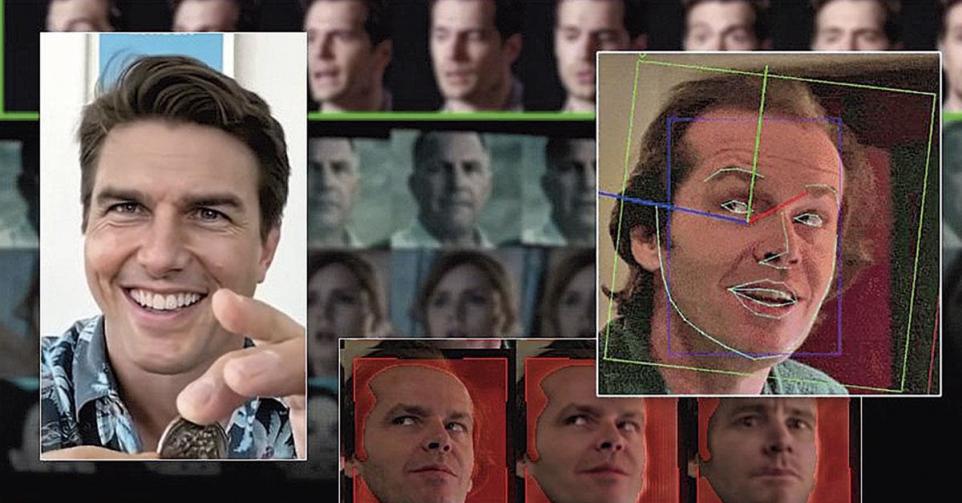

On n’arrête pas le progrès. Un simple tour sur TikTok suffit pour épier Tom Cruise en train de vanter les bienfaits de produits ménagers, serpillière à la main. Il ne s’agit évidemment pas du vrai acteur mais de sa doublure synthétique, DeepTom, joyeuse imposture permise par l’expert en effets spéciaux Chris Umé. Le Limbourgeois trentenaire a cofondé Metaphysic, société qui développe pour l’industrie du divertissement et les grandes marques des outils d’édition de contenus hyperréalistes, basés sur l’intelligence artificielle (IA). Il imagine des univers virtuels peuplés de nos parfaits jumeaux numériques.

Ça, c’est pour le côté amusant de la technologie… Mais il est des usages bien moins innocents des deepfakes, facilités par l’énorme quantité de vidéos et d’enregistrements vocaux disponibles sur le web. A commencer par le politique, pour compromettre certaines personnalités ou désinformer les citoyens… Sur le front cyber de la guerre en Ukraine, par exemple, on a connu un épisode symbolique en mars dernier: le président Volodymyr Zelensky apparaissait sur le site piraté d’une chaîne nationale pour annoncer sa capitulation et exhorter ses troupes à déposer les armes. La supercherie ne convainquit guère, tant l’incrustation et l’animation du faux chef d’Etat étaient de piètre qualité, mais ce n’est pas toujours le cas.

Il est effectivement de plus en plus difficile de distinguer les objets ou visages générés par les intelligences artificielles. Et les études menées en la matière, comme celle de l’Université de Lancaster (*), montrent que nous aurions tendance à accorder davantage confiance aux visages de synthèse qu’aux réels, ce qui soulève des questions sur l’impact de la criminalisation, voire la militarisation, des deepfakes. Les entreprises, entre autres, ne sont pas à l’abri d’un usage frauduleux de ces hypertrucages.

Lire aussi | La cybersécurité, un nouvel enjeu pour les PME

Fraude au PDG améliorée

“Les deepfakes ont le potentiel de devenir un outil courant dans les hameçonnages et autres fraudes”, notent les analystes de la société de stratégie commerciale CB Insights. Par exemple, le deepfake met à jour de vieilles tactiques telles que la “fraude au PDG”. Auparavant, il suffisait à l’escroc d’envoyer un e-mail bien imité – prétendument d’un supérieur hiérarchique – à un employé de l’entreprise pour avoir accès à des données ou se faire verser une somme d’argent. Aujourd’hui, l’intelligence artificielle permet d’imiter la voix du patron au téléphone, ou même son visage lors d’une visioconférence. En 2020, des escrocs ont ainsi dupé le manager d’une banque aux Emirats arabes unis en exigeant un transfert de 35 millions de dollars grâce à la voix clonée de son supérieur.

En juin dernier, le FBI alertait sur un autre usage du deepfake: l’entretien d’embauche en visio. Cette pratique, devenue courante dans de grandes sociétés pour pourvoir leurs postes vacants depuis la crise du covid, permet aux faussaires armés d’une IA d’accéder à des informations sensibles.

Technologie autrefois réservée à des chercheurs et des ingénieurs en IT, le deepfake n’a jamais été aussi accessible via les app stores et les sites web. “Il existe des places de marché sur lesquelles des acheteurs postent des demandes de vidéos hypertruquées. Certaines entreprises fournissent des deepfakes comme produit ou même comme service en ligne”, signale-t-on au laboratoire d’innovation d’Europol.

La réaction des autorités

Ces avancées techniques et leur détournement prennent souvent de vitesse les législateurs et les autorités judiciaires. Aux Etats-Unis, certaines juridictions ont déjà réagi: elles imposent des conditions de création et de diffusion hyper- restrictives pour limiter le danger de ces deepfakes. Des acteurs de premier plan comme Meta (anciennement Facebook) ont également banni ces montages de leurs plateformes, sauf s’ils ont clairement pour objet la satire ou la parodie.

En Europe, d’avis d’experts, la législation sur les services numériques (Digital Service Act) s’attaque mollement au problème en demandant une labellisation du contenu inauthentique. En Belgique, le secrétaire d’Etat à la Digitalisation a eu l’occasion, lors d’une intervention au Parlement, de se dire conscient du “réel défi” que représente l’émergence de ces usurpations d’identité de nouvelle génération. Mathieu Michel a d’ailleurs estimé que notre arsenal juridique n’y apportait qu’une réponse partielle.

Les services de sécurité belges seraient “briefés”, un groupe de travail pour les menaces hybrides examinerait les cas et une task force dédiée aurait été mise sur pied. Pas de quoi convaincre de la gravité des enjeux nos entreprises, déjà réticentes à investir plus dans la cybersécurité… jusqu’au jour où elles font les frais d’une attaque.

De faibles moyens de défense

Il est bien question d’une menace globale de cybersécurité, émergente mais croissante. “La capacité des ordinateurs ou des utilisateurs de distinguer ce qui est vrai de ce qui est faux est en train de tendre vers zéro”, a assuré aux analystes de CB Insights l’ingénieur du Microsoft Research Lab, Paul England.

Certes, il est encore possible à l’heure actuelle de détecter manuellement la grande majorité des contenus manipulés en recherchant les incohérences. Mais cette intervention chirurgicale s’avère coûteuse en formation et en temps de traitement. Idéalement, un système pourrait scanner tout contenu numérique et évaluer automatiquement son authenticité. Des initiatives privées vont d’ailleurs dans ce sens. Soutenant que même une défense assistée par une intelligence artificielle ne pourra pas combattre complètement les deepfakes, Microsoft a ainsi initié Project Origin, un service qui permet d’authentifier les médias numériques à l’aide de métadonnées inviolables. OEuvrant pour la mise en place d’une norme industrielle officielle, le géant de l’informatique s’est également associé avec cinq autres entreprises (dont Adobe, Intel et la BBC) pour fonder la Coalition for Content Provenance and Authenticity. Car il va de soi que l’authenticité des contenus ne peut être garantie que si les méthodes d’authentification sont adoptées à grande échelle.

Même la police s’y met

Aux Pays-Bas, la police de Rotterdam a diffusé en mai de cette année un deepfake mettant en scène un mort afin de susciter de nouveaux témoignages dans une ancienne affaire. En 2003, Sedar Soares, un garçon de 13 ans fan de football, avait été assassiné sur un parking. Pour retrouver des témoins, la police a donc ressuscité le garçon qui marche, ballon sous le bras, entre une haie de parents, d’amis et de policiers.

D’autres solutions évolutives

Les entreprises s’efforcent de trouver de nouveaux moyens pour détecter et neutraliser les deepfakes qui les menacent. Big tech, consortiums et start-up expérimentent des approches en tous genres: logiciels d’authentification embarqués sur les appareils, marqueurs cryptographiques, etc.

Citons également le projet européen de plateforme collaborative de détection WeVerify, ainsi que la plateforme Reality Defender, initiée par l’AI Foundation en 2020, promettant des analyses complètes pour des résultats applicables. Les internautes peuvent y soumettre tout contenu suspect (vidéo, image ou enregistrement audio). Sans jamais oublier que la nature évolutive de ce défi technologique exige des efforts d’éducation de la part des politiques, des dirigeants et des consommateurs

(*) AI-SYNTHESIZED FACES ARE INDISTINGUISHABLE FROM REAL FACES AND MORE TRUSTWORTHY, WWW.PNAS.ORG

Vous avez repéré une erreur ou disposez de plus d’infos? Signalez-le ici